📄 Paper de la Semana: OpenForecaster

- Paper: Scaling Open-Ended Reasoning to Predict the Future

- Autores: Csaky et al. (Berkeley, JHU, et al.)

- Publicación: 31 de diciembre, 2025 (Trending week of Jan 10)

- GitHub: OpenForecaster/scaling-forecasting-training

🎯 ¿Por qué es relevante?

Predecir eventos futuros (forecasting) ha sido tradicionalmente territorio de expertos humanos o modelos estadísticos muy específicos. OpenForecaster demuestra que un LLM relativamente pequeño (8B parámetros), si se entrena específicamente para razonar sobre noticias y causalidad, puede superar a modelos propietarios masivos (como GPT-4o sin fine-tuning) en tareas de predicción probabilística. Es un paso gigante para la inteligencia estratégica automatizada.

🔬 Detalles Técnicos

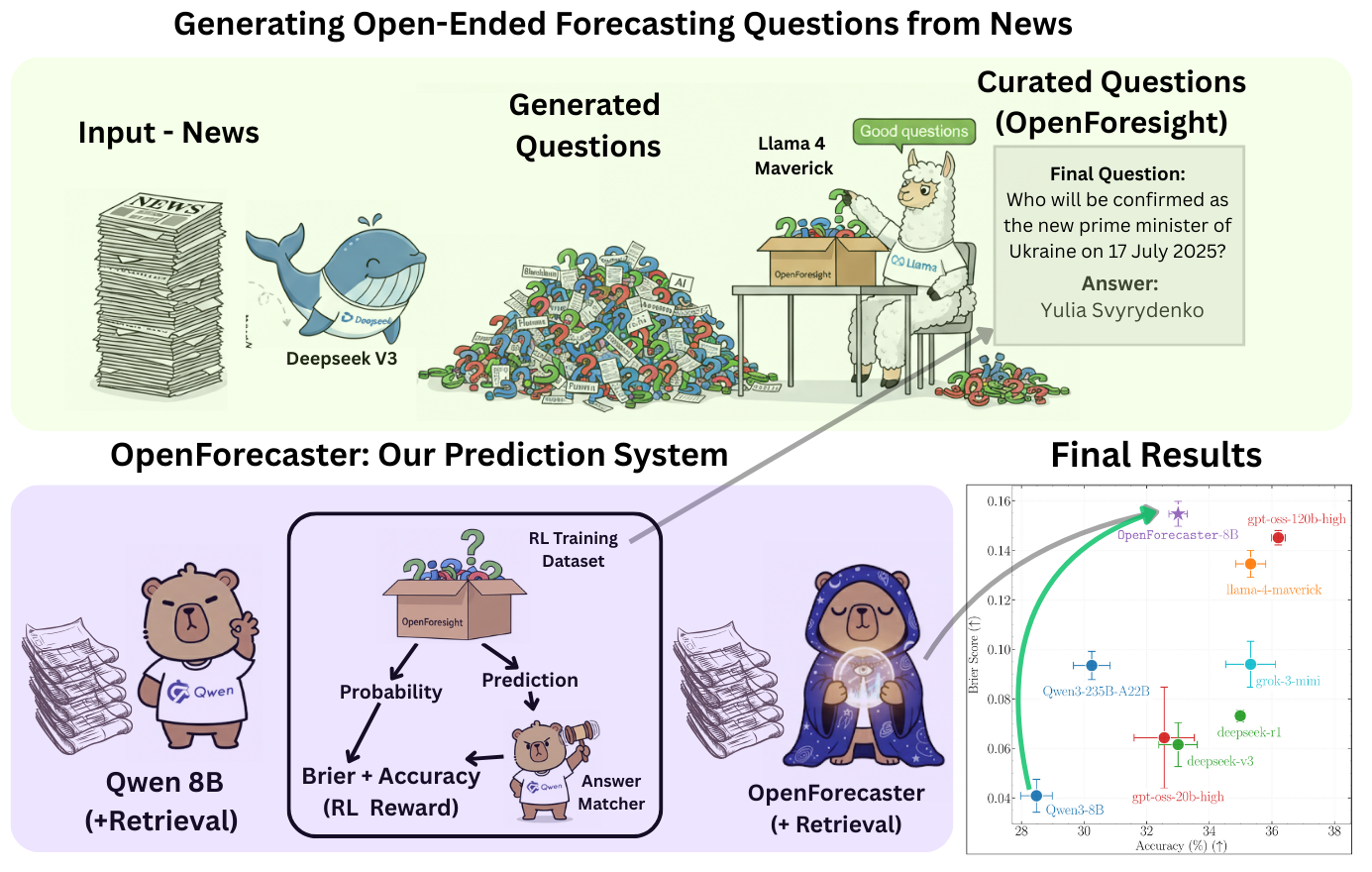

La innovación principal reside en cómo transformaron el problema de predicción en un problema de razonamiento y recuperación:

- OpenForesight Dataset: Crearon un dataset masivo extrayendo noticias históricas y sus desenlaces reales. No solo pares (evento, resultado), sino cadenas de razonamiento que conectan ambos.

- Retrieval-Augmented Reasoning: El modelo no predice en el vacío. Ante una pregunta (e.g., “¿Subirá el precio del petróleo la próxima semana?”), primero recupera noticias relevantes del periodo anterior a la fecha objetivo.

- Fine-tuning en Pasos: Entrenaron a Llama-3.1-8B para seguir un proceso estructurado:

- Analizar la relevancia de las noticias recuperadas.

- Generar un razonamiento causal (pros/contras).

- Emitir una probabilidad calibrada final.

El resultado es un modelo que no solo da un número (e.g., “75% probable”), sino que te explica por qué, citando eventos específicos que fundamentan su predicción.

💡 Opinión

OpenForecaster democratiza el “superforecasting”. Lo más interesante no es solo que prediga bien, sino que su razonamiento es transparente. Esto abre la puerta a asistentes de toma de decisiones que actúan como analistas de inteligencia, capaces de digerir el caos de las noticias diarias y convertirlas en probabilidades accionables.