📄 Paper de la Semana: DeepSeek-V3

- Paper: DeepSeek-V3 Technical Report

- Autores: DeepSeek-AI

- Publicación: 27 de diciembre, 2025 (Trending week of Jan 3)

- GitHub: deepseek-ai/DeepSeek-V3

🎯 ¿Por qué es relevante?

Si 2025 fue el año de “más es mejor”, DeepSeek cierra el año gritando “más inteligente es mejor”. DeepSeek-V3 ha sacudido la industria no solo por igualar a GPT-4 y Claude 3.5 en benchmarks clave, sino por hacerlo con una fracción del coste de entrenamiento (aprox. $5.5M vs los cientos de millones estimados de sus rivales). Es la prueba de que la innovación algorítmica pesa tanto o más que la fuerza bruta computacional.

🔬 Detalles Técnicos

La “magia” de V3 reside en dos pilares arquitectónicos:

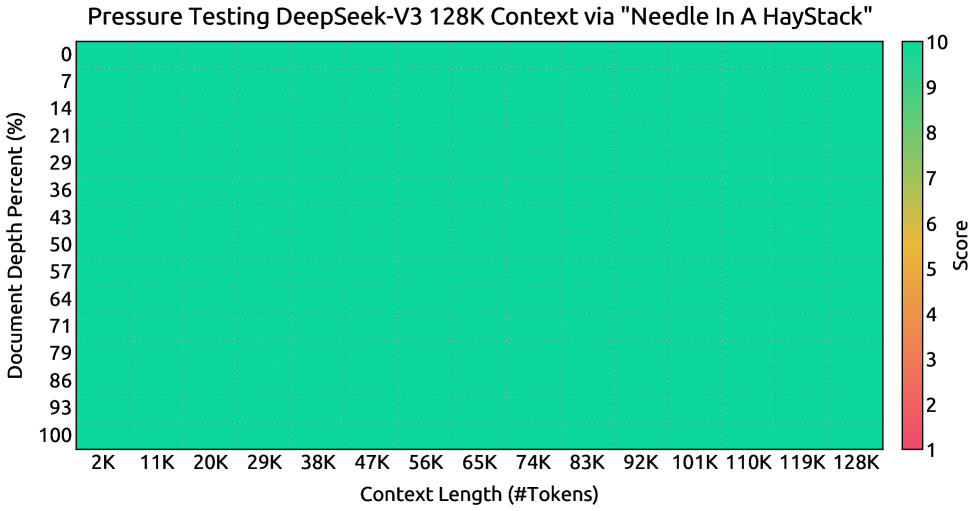

- Multi-head Latent Attention (MLA): Una optimización agresiva del mecanismo de atención que reduce drásticamente el uso de memoria (KV cache) durante la inferencia, permitiendo contextos largos y respuestas rápidas sin sacrificar rendimiento.

- DeepSeekMoE (Mixture-of-Experts) con Load Balancing Auxiliar:

- Total de 671 mil millones de parámetros, pero solo 37 mil millones se activan por token.

- Utilizan una estrategia de load balancing sin pérdida (auxiliary-loss-free) que evita que los expertos se infrautilicen o saturen, un problema clásico en modelos MoE.

- FP8 Training: Entrenado nativamente en precisión mixta FP8, exprimiendo al máximo cada ciclo de reloj de sus clusters H800.

💡 Opinión

DeepSeek-V3 es un aviso para navegantes: el muro de la computación no es tan impasable como parecía. Al publicar los detalles técnicos y liberar los pesos (bajo licencia permisiva), DeepSeek no solo compite, sino que acelera a toda la comunidad open-source. La barrera de entrada para tener un modelo de nivel GPT-4 en local (o en servidores modestos) acaba de derrumbarse.